【论文精读】HunyuanCustom:多模态驱动的定制视频生成架构

【论文精读】HunyuanCustom:多模态驱动的定制视频生成架构

摘要

腾讯提出的HunyuanCustom框架解决视频定制化生成中的身份一致性问题,通过图像ID增强与文本-图像融合技术,实现多模态控制(文本、图像、音频、视频)下的身份保持,支持虚拟人物广告、试穿和视频编辑等多种应用场景。

目录

背景与研究目标

领域背景与任务定义

定制化视频生成是一种先进的内容创作技术,旨在根据用户提供的参考素材创建个性化视频内容。这一领域的核心需求包括主体身份一致性保持、多模态条件控制和高质量输出,确保生成内容既满足用户个性化需求,又保持专业品质。该技术的应用场景广泛,覆盖虚拟人物广告、虚拟试穿、视频编辑等多个商业领域,为数字内容创作和营销提供了革命性的解决方案。

现有方法的局限性

- ConsisID和MovieGen专注于单一人物ID生成,无法处理任意对象

- ConceptMaster、Video Alchemist和Phantom等方法虽支持多主体生成,但身份一致性和视频质量仍有不足

- VACE等基于多模态的方法训练任务过多,导致ID一致性受损

- 大多方法仅支持单一模态输入(图像驱动),限制了应用范围

论文要解决的核心问题

- 如何在保持主体身份一致性的同时支持多模态条件控制

- 如何实现文本、图像、音频和视频条件的有效解耦和组合

- 如何优化工程策略,提高定制化视频生成的质量和效率

方法与创新点

整体架构与技术路线

HunyuanCustom基于混元视频大模型构建,主要解决"让AI记住并保持视频中人物或物体的身份特征"这一核心问题:

系统由四个核心模块组成:

主体驱动视频生成:

- 将参考图像视为视频的"第-1帧",帮助模型记住目标对象的外观

- 通过特殊编码技术实现身份信息的时空传递,保持视觉一致性

文本-图像理解:

- 利用大语言模型(LLaVA)理解"这是谁"和"要做什么"

- 使用特殊标记

<SEP>平衡文本和图像信息,避免任一方主导生成过程

视频条件控制:

- 采用轻量级特征对齐技术,使新生成的视频能借鉴参考视频的动作

- 通过加法融合而非拼接,大幅降低计算需求

音频驱动机制:

- 实现语音或音乐与视频的精确同步

- 通过空间注意力技术确保口型与语音内容匹配

数据处理的关键

高质量的视频定制需要高质量的数据支持,HunyuanCustom在数据处理上做了精心设计:

- 智能筛选:使用场景检测和质量评估工具,筛选出连贯且美观的视频片段

- 主体提取:针对人物和非人物主体采用不同的提取策略,确保特征完整

- 数据增强:通过掩码变换和标准化处理,提高模型的泛化能力

"记忆保持"的核心技术

HunyuanCustom解决身份一致性问题的关键在于创新性地将身份信息嵌入时间维度:

- 时间轴记忆:将参考图像作为视频的"前导帧",使模型在生成每一帧时都能回溯参考

- 位置编码:通过特殊的3D位置编码技术,标记身份信息的特殊地位

- 空间位移:通过轻微移动参考图像的空间位置,避免模型简单复制粘贴

这些技术让模型能够"记住"主体特征,同时保持生成的灵活性和创造性。

多模态控制的灵活组合

HunyuanCustom实现了不同输入信号的解耦与自由组合:

| 控制什么 | 技术方案 | 类比解释 |

|---|---|---|

| 身份外观 | 时序身份记忆 | 就像演员的"造型" |

| 动作场景 | 文本提示词控制 | 相当于"剧本指导" |

| 语音口型 | 音频空间注意力 | 类似"配音同步" |

| 动作参考 | 视频特征对齐 | 如同"动作指导" |

这种设计使创作者能够独立控制视频的不同方面,就像导演可以分别指导演员的造型、表演和配音一样灵活。

实验与结果分析

与业界方案的比较

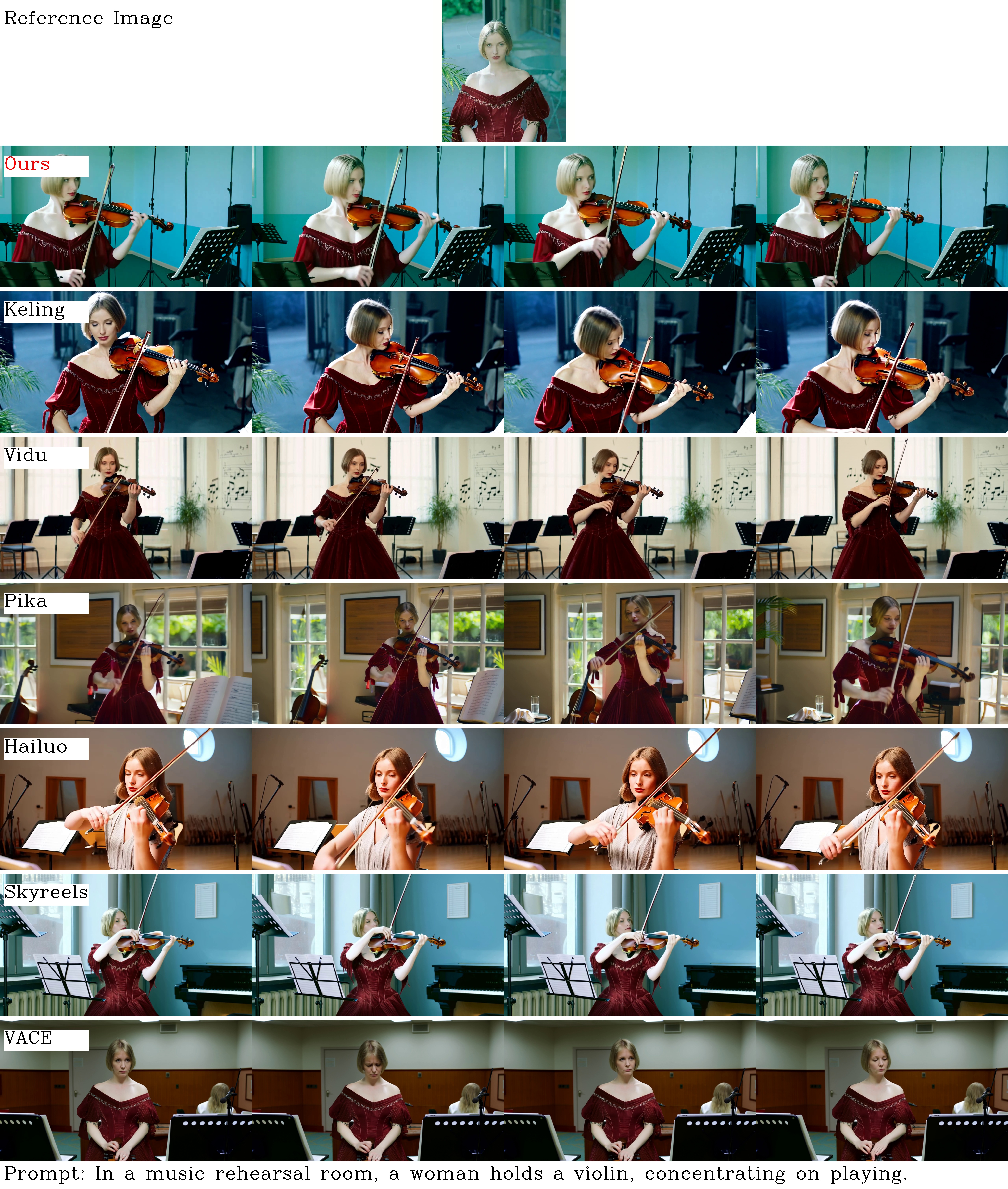

HunyuanCustom与多种商业产品(Vidu 2.0、Keling 1.6、Pika、Hailuo)和开源方法(SkyReels-A2、VACE)进行了全面对比:

上图显示了不同模型生成的小提琴演奏者视频效果。可以看出,HunyuanCustom(标记为"Ours")在人物面部特征、发型和整体外观的一致性方面明显优于其他方法。

在精确度量上,HunyuanCustom在所有主要指标上都取得了领先:

| 模型方法 | Face-Sim ↑ | DINO-Sim ↑ | CLIP-B-T ↑ | Temp-Consis ↑ | DD ↑ |

|---|---|---|---|---|---|

| SkyReels-A2 | 0.785 | 0.814 | 0.293 | 0.956 | 0.521 |

| VACE | 0.793 | 0.823 | 0.301 | 0.962 | 0.547 |

| Vidu 2.0 | 0.823 | 0.839 | 0.316 | 0.968 | 0.562 |

| Keling 1.6 | 0.817 | 0.832 | 0.311 | 0.967 | 0.558 |

| Pika | 0.811 | 0.829 | 0.305 | 0.965 | 0.552 |

| Hailuo | 0.815 | 0.835 | 0.308 | 0.963 | 0.549 |

| HunyuanCustom | 0.852 | 0.861 | 0.332 | 0.973 | 0.586 |

这些指标分别测量了面部相似度、整体物体相似度、与文本描述的匹配度、时间连贯性和动态自然度。

多种应用场景展示

物品定制化视频

HunyuanCustom不仅能处理人物主体,还能精确捕捉物品的特征并将其放入不同场景中。

多主体协同生成

在多主体场景中,HunyuanCustom能同时保持多个角色的身份特征,并生成它们之间的自然互动。

音频驱动视频

当输入音频时,系统能生成口型精确匹配的视频,为配音和虚拟主播提供了可靠的技术支持。

实用性与资源效率

HunyuanCustom特别注重实用性和资源效率:

- 单张消费级GPU(如RTX 3090)即可完成模型训练和推理

- 训练时间和存储空间显著低于传统方法

- 全流程工具链降低了使用门槛,适合中小企业应用

消融实验表明,模型各组件设计合理,在效率和性能间达到了良好平衡。

模型启发与方法延伸

方案通用性:

- 适用于各类Transformer架构的视频生成模型

- 可扩展到其他多模态生成任务场景

企业应用启示:

- 推荐小数据场景下的渐进式训练策略

- 模型能力评测的多维度框架设计

- 数据质量先于数量的原则验证

结论与未来展望

论文贡献总结

- 提出完整的大模型定制化工程解决方案

- 实现高效低成本的专业能力提升

- 开源训练框架促进技术生态发展

方法优势与不足

优势:

- 视频生成训练资源需求低,适合广泛应用

- 全流程视频定制工具链,降低使用门槛

- 灵活配置,支持不同规模的视频生成需求

局限:

- 对特定极端视频场景的处理能力有限

- 需要一定质量的专业视频数据支持

- 超大规模视频生成模型的优化仍有提升空间

未来研究方向

- 探索更高压缩比的视频生成参数高效微调方法

- 研究跨模态、跨语言的统一视频定制框架

- 发展自适应视频数据筛选与增强技术