【论文精读】OmniGen2:探索先进多模态生成(OmniGen2: Advancing Unified Multimodal Generation)

大约 6 分钟

【论文精读】OmniGen2:探索先进多模态生成(OmniGen2: Advancing Unified Multimodal Generation)

摘要

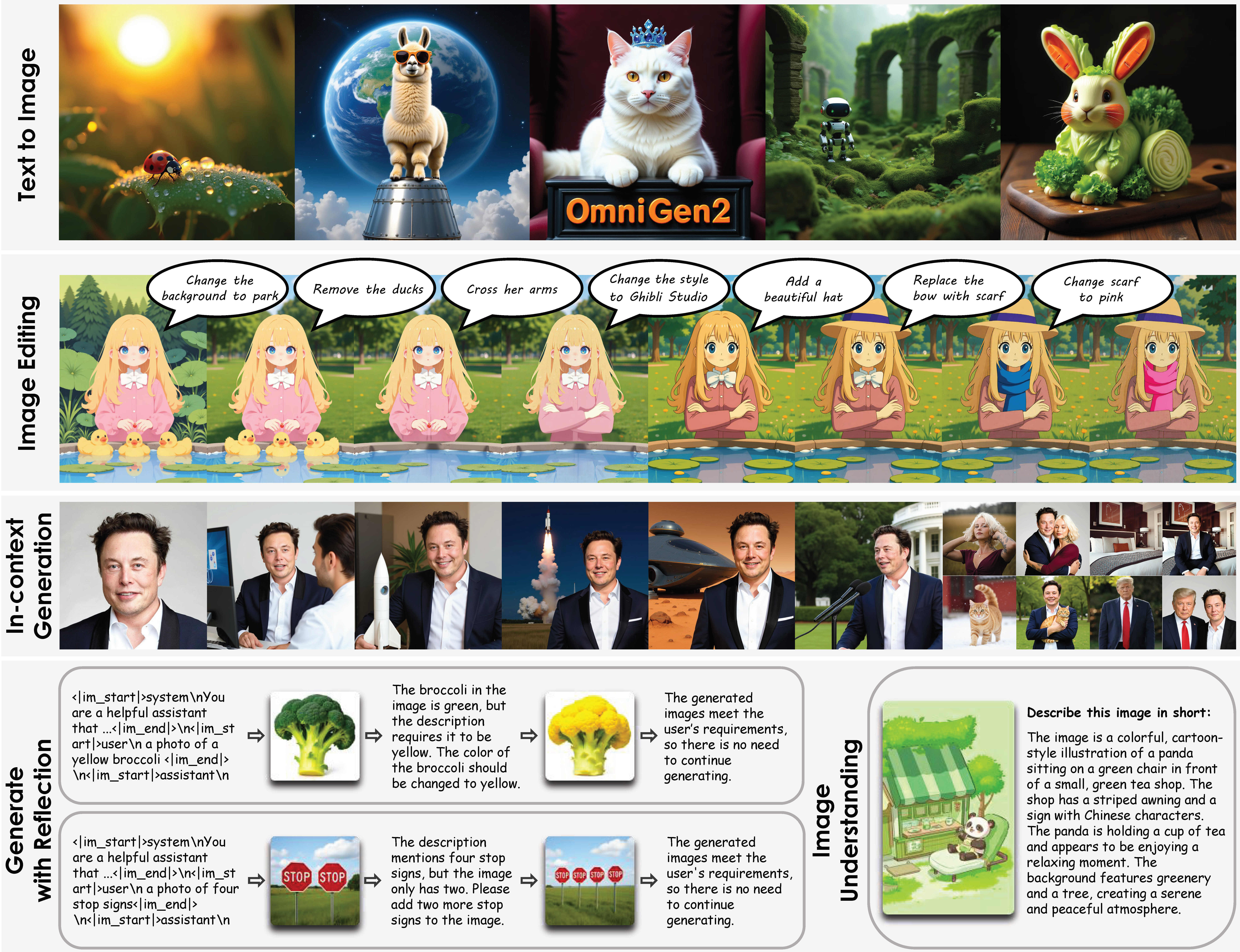

OmniGen2 是 BAAI 推出的多模态开源模型,统一文本到图像、图像编辑和情境生成。其解耦架构与视频数据管道显著提升理解与生成能力,在多项主流基准上表现领先,并开源全部资源,推动多模态发展。

目录

背景与研究目标

- 多模态生成(文本、图像等)是通用人工智能的重要方向,现有方法多为任务专用,缺乏统一高效的通用架构。

- 传统开源模型在数据多样性、指令理解和上下文一致性等方面存在明显短板。

- OmniGen2 旨在通过解耦架构和创新数据管道,实现文本到图像、图像编辑和情境生成的统一,提升多模态模型的泛化能力和实际应用价值。

- 论文提出 OmniContext 基准,系统评估模型在复杂情境下的生成与理解能力。

方法与创新点

1. 解耦多模态架构

OmniGen2 采用彻底解耦的多模态架构:

- 理解路径:冻结 Qwen2.5-VL-3B 多模态大语言模型(MLLM),负责文本与视觉理解,仅训练特殊 token “<|img|>”,其余参数保持冻结。MLLM 通过文本分词器和视觉 ViT 分词器处理输入,输出丰富的隐藏状态,作为条件传递给生成路径。

- 生成路径:独立的 40 亿参数扩散 Transformer,直接接收 VAE 提取的视觉特征,保留细粒度视觉细节,避免信息压缩丢失。VAE 特征完全绕过 MLLM,提升生成质量。

- 对齐机制:MLLM、VAE 特征和噪声输入通过精炼网络对齐,扩散解码器采用整流流(Rectified Flow)进行高效训练。

2. Omni-RoPE 多模态位置编码

OmniGen2 引入 Omni-RoPE(多模态旋转位置嵌入),将位置信息分解为:

- 序列/模态 id(id_seq)

- 归一化垂直位置(h)

- 归一化水平位置(w)

这种设计支持多图像输入时空间关系一致性与身份区分,保证编辑和合成任务的空间精度。

3. 基于视频的数据构建管道

OmniGen2 采用创新的数据构建流程,极大缓解高质量多模态数据稀缺问题:

- 情境生成:自动提取视频帧,Qwen2.5-VL-7B-Instruct 识别主体,GroundingDINO 获取边界框,SAM2 跟踪主体,FLUX.1-Fill-dev 外绘增强多样性,VLM/DINO 过滤一致性。

- 图像编辑:帧对内外绘,MLLM 生成精确编辑指令,确保指令与视觉变化高度相关。

- 传统编辑:对高质量文本到图像输出随机内绘,MLLM 生成指令,提升编辑数据的真实性和多样性。

4. 多模态反思机制

OmniGen2 借鉴大语言模型“思维链”推理,提出多模态反思机制:

- 生成初稿后,模型自我分析输出,识别细节错误(如对象数量、颜色、形状等),并生成修正版。

- 反思过程可多轮迭代,直至满足指令或模型自我终止。

- 显著提升复杂任务下的生成质量与鲁棒性。

实验与结果分析

1. 实验设置与数据集

- 评测基准涵盖 GenEval、DPG-Bench、ImgEdit-Bench、Emu-Edit、MMBench、MMMU、MM-Vet 等,覆盖文本到图像、图像编辑、情境生成等多任务。

- 采用 OmniContext 作为复杂情境生成的系统性评测标准。

2. 多项主流基准测试表现

| 任务/基准 | OmniGen2 (7B) | BAGEL (14B) | 评测指标/说明 |

|---|---|---|---|

| GenEval | 0.86 | 0.87 | 文生图综合分数 |

| DPG-Bench | 83.57 | 83.60 | 指令遵循与一致性 |

| ImgEdit-Bench | SOTA | - | 图像编辑任务 |

| Emu-Edit (CLIP-Out) | 0.309 | 0.308 | 编辑区域对齐分数 |

| MMBench | 79.1 | 80.2 | 多模态理解 |

| MMMU | 53.1 | 54.0 | 多模态推理 |

| MM-Vet | 61.8 | 62.1 | 多模态推理 |

OmniGen2 以 7B 参数(3B MLLM + 4B Diffusion)实现与更大模型 BAGEL 14B 相当的性能,且在图像编辑等任务上表现突出。

3. 任务与能力可视化

多任务统一:

主体驱动生成:

传统视觉任务:

一步条件生成对比:

4. 消融实验与反思机制效果

反思机制提升:

逐步生成过程:

5. OmniContext 基准与复杂情境评测

- OmniContext:论文引入 OmniContext 基准,系统评估模型在角色、物体、场景等复杂情境下的指令遵循与主体一致性。

- 评测示例:

6. 典型失败案例与局限性

模型启发与方法延伸

- 解耦架构证明:冻结大语言模型+专用扩散模型可兼顾多模态理解与高质量生成,适合资源有限场景。

- 数据构建范式创新:基于视频的数据构建流程为多模态训练和评测树立新范式,极大缓解了高质量数据稀缺问题。

- 反思机制推广:反思机制为自修正生成式 AI 提供了可行路径,有望推广至更多多模态任务。

- 评测标准推动:OmniContext 基准推动了多模态生成领域的系统性评测标准化。

结论与未来展望

- OmniGen2 以高效、解耦的架构实现了多模态生成的统一,性能媲美甚至超越更大规模模型。

- 论文开源了模型、训练代码、数据集和数据构建流程,极大促进了学术与产业的协同发展。

- 局限性包括中英文提示性能差异、人体形状编辑能力有限、反思机制偶有过度或无效修正、低分辨率输入影响输出质量等。

- 未来可在数据多样性、模型规模、指令理解和反思机制等方面持续优化,推动多模态生成迈向更高智能与实用性。