Qwen2.5定义多模态模型新高度|DeepSeek-V3突破混合专家能力|Mulberry强化推理反思【AI周报】

Qwen2.5定义多模态模型新高度|DeepSeek-V3突破混合专家能力|Mulberry强化推理反思【AI周报】

摘要

本周聚焦大模型与多模态:Qwen2.5 优化预训练与后训练,定义多模态模型新标准;DeepSeek-V3 引入混合专家架构,提升训练效率;Mulberry 结合蒙特卡罗树搜索,增强推理与反思能力。详见正文。

目录

- Qwen2.5:阿里巴巴达摩院推出的多模态大模型

- DepthLab:从部分到完整的深度补全模型

- PAR:并行自回归视觉生成

- DeepSeek-V3:6710亿参数的混合专家语言模型

- DiT-CTRL:多模态扩散Transformer中的注意力控制探索

- Mulberry:通过集体蒙特卡罗树搜索增强多模态大模型的推理与反思能力

Qwen2.5:阿里巴巴达摩院推出的多模态大模型

概要:Qwen2.5 是阿里巴巴达摩院发布的多模态大模型系列,旨在满足多样化需求。相比之前的版本,Qwen2.5 在预训练和后训练阶段均有显著提升。预训练方面,模型的高质量预训练数据集从7万亿标记扩展至18万亿标记,增强了常识、专业知识和推理能力。后训练阶段,采用了超过100万样本的精细监督微调和多阶段强化学习,提升了模型的人类偏好对齐能力,特别是在长文本生成、结构化数据分析和指令遵循方面。Qwen2.5 系列提供多种规模的模型,包括基础模型和指令微调模型,并提供量化版本,以适应不同的使用场景。其中,Qwen2.5-72B-Instruct 在语言理解、推理、数学、编码和人类偏好对齐等基准测试中表现出色,超越了许多开源和专有模型。此外,Qwen2.5 还支持训练专用模型,如 Qwen2.5-Math、Qwen2.5-Coder 和多模态模型。

标签:#Qwen2.5 #阿里巴巴达摩院 #多模态模型 #大规模预训练 #强化学习

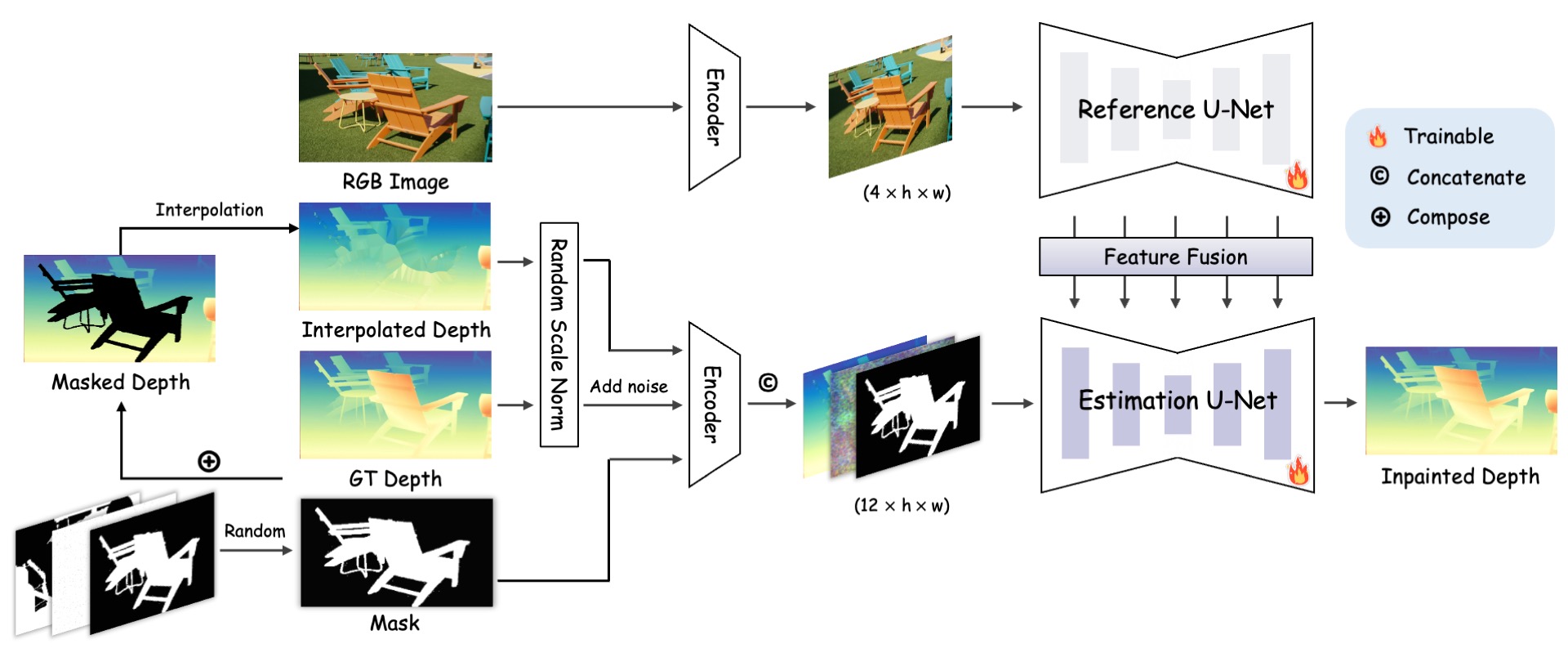

DepthLab:从部分到完整的深度补全模型

概要:DepthLab 是一款由香港大学、香港科技大学和蚂蚁集团的研究人员联合开发的深度补全基础模型,旨在解决深度数据中常见的缺失问题。该模型利用图像扩散先验,能够在已知深度的条件下,可靠地填补缺失区域,保持尺度一致性。DepthLab 在多个下游任务中表现出色,包括 3D 场景修复、文本到 3D 场景生成、稀疏视图重建和 LiDAR 深度补全,超越了现有方法的性能。

标签:#DepthLab #深度补全 #图像扩散 #3D场景 #LiDAR

PAR:并行自回归视觉生成

概要:PAR(Parallelized Autoregressive Visual Generation)是一种旨在提升视觉生成效率的模型。传统的自回归模型逐个生成视觉数据的每个token,速度较慢。PAR通过并行生成弱依赖性的远距离token,同时对强依赖性的局部token保持顺序生成,从而加快生成过程。该方法无需修改模型架构或tokenizer,即可集成到标准自回归模型中。在ImageNet和UCF-101上的实验表明,PAR在图像和视频生成任务中实现了3.6倍的速度提升,且生成质量与传统方法相当。

标签:#PAR #自回归模型 #视觉生成 #并行生成 #深度学习

DeepSeek-V3:6710亿参数的混合专家语言模型

概要:DeepSeek-V3 是由 deepseek-ai 开发的混合专家(MoE)语言模型,总参数量达 6710 亿,每个 token 激活 370 亿参数。该模型采用多头潜在注意力(MLA)和 DeepSeekMoE 架构,结合无辅助损失的负载均衡策略和多 token 预测训练目标,提升了推理效率和训练成本效益。在 14.8 万亿高质量多样化 token 上进行预训练,并经过监督微调和强化学习阶段,展现出卓越的性能,超越了其他开源模型,并与领先的闭源模型相媲美。完整训练耗时约 278.8 万 H800 GPU 小时,过程稳定,无需回滚。

标签:#DeepSeek-V3 #混合专家模型 #语言模型 #深度学习 #人工智能

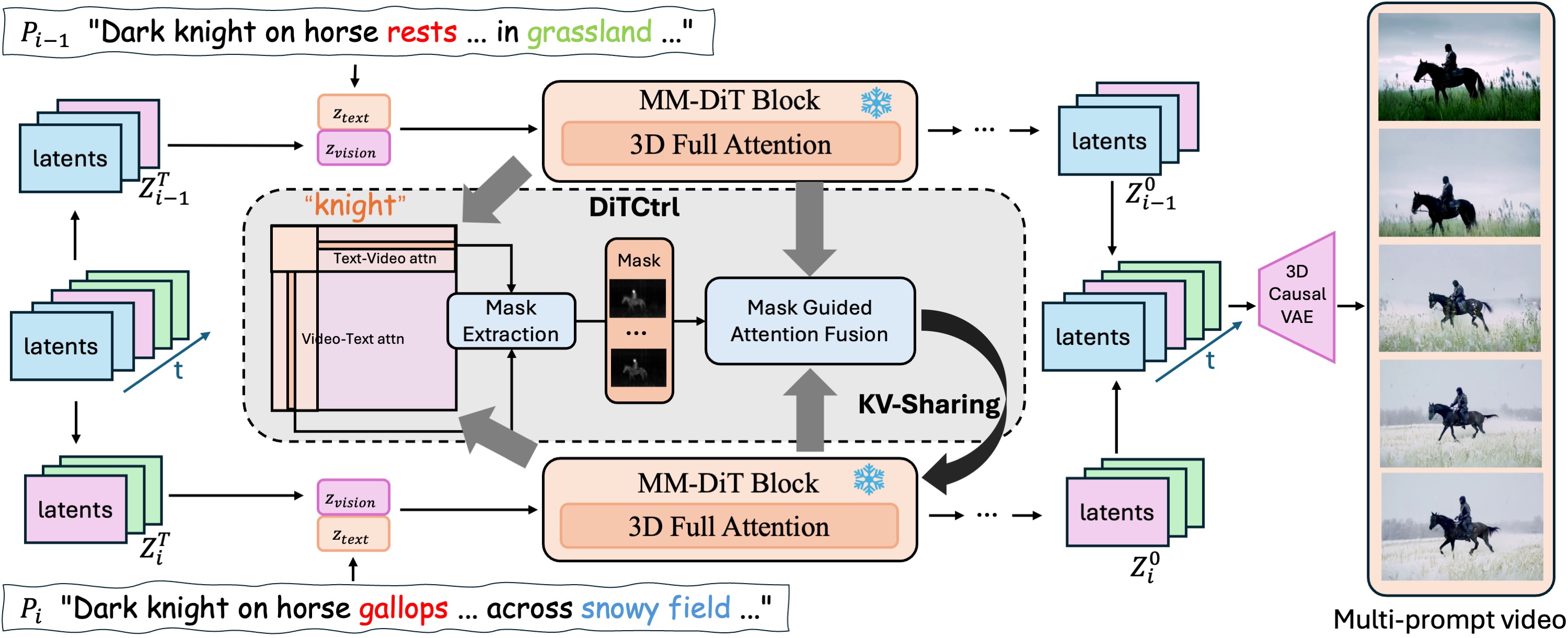

DiT-CTRL:多模态扩散Transformer中的注意力控制探索

概要:DiT-CTRL是一种无需额外训练的多提示词视频生成方法,旨在解决现有模型在生成包含多个顺序提示词的视频时,缺乏连贯性和自然过渡的问题。通过分析多模态扩散Transformer(MM-DiT)的注意力机制,DiT-CTRL实现了基于掩码的精确语义控制,使生成的视频在不同提示词之间具有平滑过渡和一致的对象运动。实验结果表明,DiT-CTRL在无需额外训练的情况下,实现了多提示词视频生成的最新性能。

标签:#DiT-CTRL #多提示词视频生成 #注意力控制 #多模态扩散Transformer #深度学习

Mulberry:通过集体蒙特卡罗树搜索增强多模态大模型的推理与反思能力

概要:Mulberry 是一种多模态大语言模型(MLLM),旨在通过集体蒙特卡罗树搜索(CoMCTS)提升模型的逐步推理与反思能力。CoMCTS 方法引入集体学习的概念,通过扩展、模拟与错误定位、回传和选择等迭代操作,协作地推测、搜索并确定有效的推理路径,直至得出正确答案。利用 CoMCTS,研究者构建了包含 26 万个多模态数据集的 Mulberry-260k,每个问题都包含丰富、明确的推理节点树。在此基础上训练的 Mulberry 模型在多个基准测试中表现出色,展现了卓越的逐步推理与反思能力。

概要:Mulberry 是一种多模态大语言模型(MLLM),旨在通过集体蒙特卡罗树搜索(CoMCTS)提升模型的逐步推理与反思能力。CoMCTS 方法引入集体学习的概念,通过扩展、模拟与错误定位、回传和选择等迭代操作,协作地推测、搜索并确定有效的推理路径,直至得出正确答案。利用 CoMCTS,研究者构建了包含 26 万个多模态数据集的 Mulberry-260k,每个问题都包含丰富、明确的推理节点树。在此基础上训练的 Mulberry 模型在多个基准测试中表现出色,展现了卓越的逐步推理与反思能力。

标签:#Mulberry #多模态大语言模型 #推理 #反思 #蒙特卡罗树搜索