Qwen-Image顶级文本渲染与编辑|UniPic1.5B模型统一多模态生成|LongVie超长视频生成【AI周报】

Qwen-Image顶级文本渲染与编辑|UniPic1.5B模型统一多模态生成|LongVie超长视频生成【AI周报】

摘要

本周亮点:Qwen-Image聚焦复杂文本渲染与高一致性图像编辑,UniPic实现统一架构下的多模态理解、生成与编辑,LongVie突破极长视频的可控生成与一致性。更多精彩内容详见正文,相关参考链接请见文末。

目录

- Qwen‑Image:面向复杂文本排版与精确图像编辑的 20B 图像基座模型

- UniPic:1.5B参数统一视觉理解、生成与编辑模型

- PixNerd:直接在像素空间高效生成高精度图像的新范式

- Magenta RealTime:Google 开源的实时交互音乐生成模型

- UniEdit-I:零训练统一视觉语言模型图像编辑框架

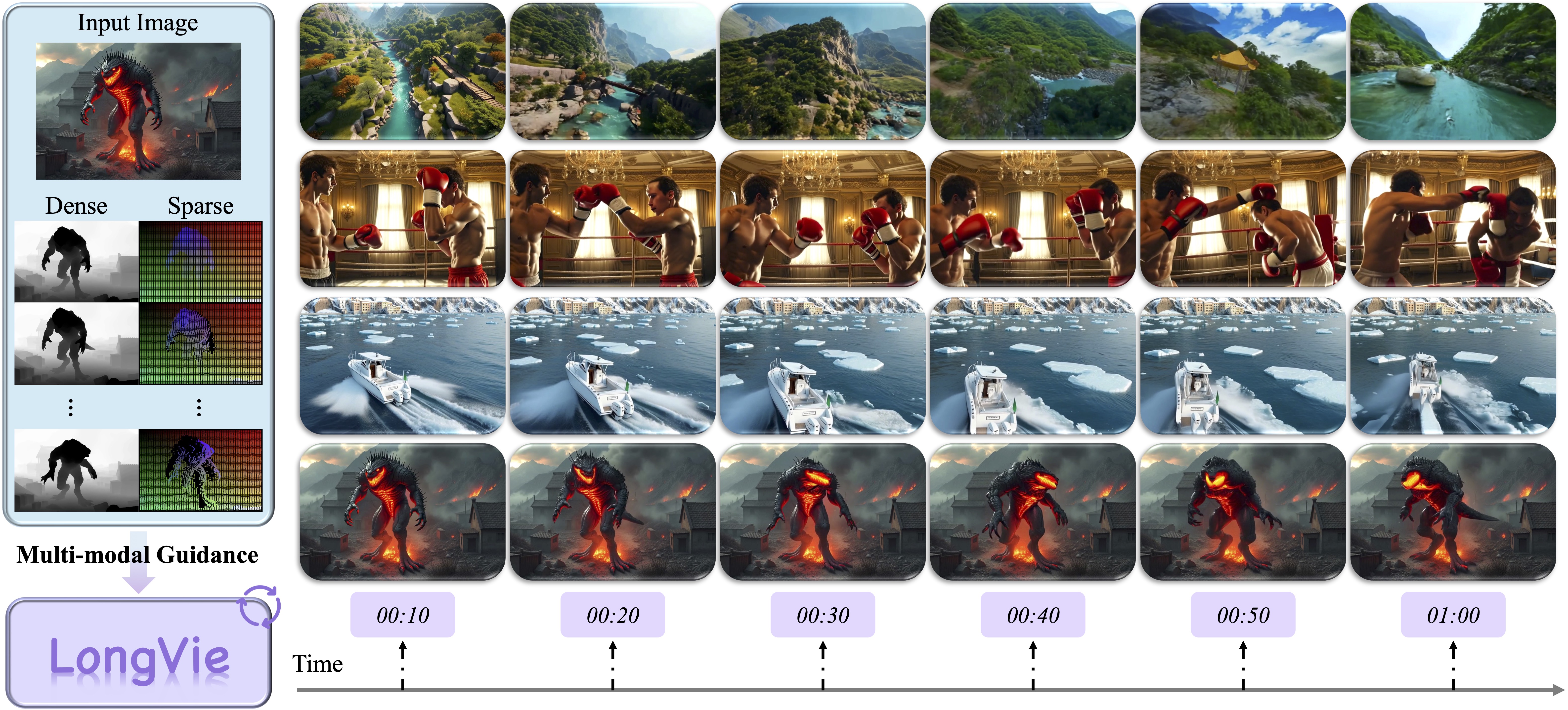

- LongVie:多模态引导的可控极长视频生成框架

Qwen‑Image:面向复杂文本排版与精确图像编辑的 20B 图像基座模型

概要:Qwen‑Image 是千问团队发布的 20B MMDiT 图像基座模型,专注解决「复杂文本在图像中原生渲染」与「高一致性的图像编辑」两大痛点。团队构建了大规模的文本-图像流水线(收集、过滤、注释、合成与均衡),并采用从简单到复杂的渐进训练策略(curriculum learning)以提升段落级、多行多字的本地文本渲染能力;同时通过双编码(将语义编码器与 VAE 重建编码分离)和多任务联合训练,增强编辑模块在保留语义一致性与视觉保真间的平衡。官方报告与基准测试显示 Qwen‑Image 在文本渲染(含中文)与图像编辑多项指标上处于领先水平,并已发布模型权重、技术报告与使用示例。

标签:#文本渲染 #图像编辑 #多任务训练 #双编码机制 #大规模数据流水线

UniPic:1.5B参数统一视觉理解、生成与编辑模型

概要:UniPic 是天工AI团队推出的 1.5B 参数统一自回归多模态模型,首次通过单一架构同时支持图像理解、文本生成图像与图像编辑任务。其创新架构结合被掩蔽的自回归编码器(用于图像合成)与 SigLIP2 编码器(用于理解),并通过共享的自回归解码器实现三任务融合。训练采用了从 256×256 到 1024×1024 的渐进训练策略、分阶段参数解冻以及精心构建的大规模多模态数据集。UniPic 在 GenEval(0.86)、DPG-Bench(85.5)、GEditBench-EN(5.83)、ImgEdit-Bench(3.49)基准上取得了 SOTA 成绩,并能在 RTX 4090 硬件下以低于 15GB 显存生成高分辨率图像。

标签:#统一多模态 #自回归模型 #分离编码 #渐进训练 #高效部署

PixNerd:直接在像素空间高效生成高精度图像的新范式

概要:PixNerd(Pixel Neural Field Diffusion)由南京大学 MCG 团队提出,是一种跳过 VAE、直接在像素空间生成图像的扩散 Transformer。它采用**神经场(Neural Field)**替代传统线性投影,用于处理大 patch 解码,从而实现单阶段、端到端的高效训练流程。模型在 ImageNet 上达到了出色的生成性能:256×256 分辨率 FID 为 2.15,512×512 为 2.84;在文本到图像任务上,PixNerd-XXL/16 在 GenEval 和 DPG 基准上分别取得 0.73 和 80.9 的高分表现,展示了在高保真图像生成及多任务扩展方面的强大能力。

标签:#像素扩散模型 #神经场解码 #端到端训练 #高保真生成 #跨任务扩展

Magenta RealTime:Google 开源的实时交互音乐生成模型

概要:Magenta RealTime 是 Google Magenta 项目最新发布的开源直播音乐生成模型,由 Lyria 团队开发。它基于约 8 亿参数的自回归 Transformer 网络,并结合 SpectroStream 音频编码器与 MusicCoCa 风格嵌入模型,实现每 2 秒生成一段高质量立体声音轨,具备实时响应文本或音频提示控制音色与风格的能力。在自动评估指标上,它领先于其他开源离线音乐生成模型,同时因模型轻量而适配本地部署,支持 Colab Demo 和未来设备端推理部署。

标签:#实时音乐生成 #自回归模型 #交互式控制 #低延迟 #风格融合

UniEdit-I:零训练统一视觉语言模型图像编辑框架

概要:UniEdit-I 是字节跳动发布的一个无需训练便可为统一视觉语言模型(VLM)赋予图像编辑能力的系统。它采用「理解—编辑—验证」的三步迭代流程:首先对源图像进行语义结构解析生成提示(Understanding),再引入时间自适应偏移执行逐步降噪编辑(Editing),最后通过验证模块评估编辑一致性并决定是否继续或停止(Verifying)。该方法在无需额外训练的前提下,实现了高保真、高一致性的图像编辑,并在 GEdit-Bench 上取得领先表现。

标签:#图像编辑 #训练免除 #迭代理解流程 #统一VLM #高保真一致性

LongVie:多模态引导的可控极长视频生成框架

概要:LongVie 是南京大学、南洋理工S-Lab、英伟达等团队联合提出的首个专注于可控、长时长(最长达1分钟)视频生成端到端自回归框架,。它通过统一的噪声初始化和全局控制信号归一化策略确保生成一致性,并结合密集(如深度图)与稀疏(如关键点)控制信号与退化感知训练机制,有效解决时间不连贯和质量退化问题。团队还发布了 LongVGenBench 基准,包含 100 条高质量的长视频,验证 LongVie 在可控性、一致性与视觉质量上实现领先表现。

标签:#超长视频生成 #生成一致性 #多模态控制 #退化感知训练 #LongVGenBench