DeepSeek-R1定义强化学习推理|EMO2高效语音驱动数字|Textoon文本生成Live2D模型【AI周报】

DeepSeek-R1定义强化学习推理|EMO2高效语音驱动数字|Textoon文本生成Live2D模型【AI周报】

摘要

本周亮点:FilmAgent实现多智能体协作虚拟电影制作;DeepSeek-R1通过强化学习提升推理性能;EMO-2单图驱动数字人;PASA增强学术搜索效率;Textoon文本生成Live2D模型。详情见正文。

目录

- FilmAgent:多智能体协作的虚拟电影制作框架

- DeepSeek-R1:通过强化学习增强大型语言模型的推理能力

- Kimi-k1.5:支持复杂推理的多模态AI助手

- EMO2:从静态图像生成动态表情

- GameFactory:自动化游戏内容生成平台

- PASA:面向学术搜索的智能代理

- Textoon:基于文本生成生动的2D卡通角色

FilmAgent:多智能体协作的虚拟电影制作框架

概要:哈尔滨工业大学(深圳)的研究团队提出了FilmAgent,这是一个基于大型语言模型(LLM)的多智能体协作框架,旨在实现虚拟3D空间中的端到端电影自动化制作。FilmAgent模拟了导演、编剧、演员和摄影师等关键角色,涵盖了电影制作的主要阶段:1. 创意开发:将初步的想法转化为结构化的故事大纲。2. 剧本写作:为每个场景详细编写对话和角色动作。3. 电影摄影:为每个镜头确定摄像机设置。各智能体通过迭代反馈和修订进行协作,从而验证中间剧本并减少幻觉现象。人类评估显示,FilmAgent在所有方面均优于基线模型,平均得分为3.98(满分5分),展示了多智能体协作在电影制作中的可行性。进一步分析表明,尽管FilmAgent使用了相对较简单的GPT-4o模型,但其表现优于单智能体模型,体现了协调良好的多智能体系统的优势。

标签:#FilmAgent #多智能体协作 #虚拟电影制作 #LLM

DeepSeek-R1:通过强化学习增强大型语言模型的推理能力

概要:DeepSeek-R1 是由中国 AI 初创公司 DeepSeek 开发的先进大型语言模型,旨在通过强化学习(Reinforcement Learning, RL)提升模型的推理能力。初始版本 DeepSeek-R1-Zero 采用大规模 RL 训练,未经过监督微调(Supervised Fine-Tuning, SFT),展现了卓越的推理性能,但存在可读性差和语言混杂等问题。为此,研究团队引入了多阶段训练和冷启动数据,开发了 DeepSeek-R1,在数学、代码和推理任务上表现出与 OpenAI-o1 相当的性能。值得注意的是,DeepSeek 将 DeepSeek-R1 完全开源,采用 MIT 许可证,允许免费商业和学术使用。此外,团队还发布了从 DeepSeek-R1 蒸馏而来的六个稠密模型(1.5B、7B、8B、14B、32B、70B),以支持研究社区。

标签:#DeepSeek-R1 #大型语言模型 #强化学习 #推理能力 #开源

Kimi-k1.5:支持复杂推理的多模态AI助手

概要:Kimi k1.5 是由中国初创公司 Moonshot AI 开发的多模态大型语言模型,旨在通过强化学习(RL)扩展大型语言模型(LLM)的能力。该模型在复杂推理任务中表现出色,在AIME、MATH-500和LiveCodeBench等基准测试中,短链式思维(short-CoT)版本的表现优于GPT-4o和Claude Sonnet 3.5,提升幅度高达550%。此外,长链式思维(long-CoT)版本在MathVista、AIME和Codeforces等多种任务中表现与o1相当。Kimi k1.5支持最长128k的上下文窗口,采用高效的训练方法,通过部分回合(partial rollouts)实现高效训练。

标签:#Kimi_k1.5 #多模态 #LLM #强化学习

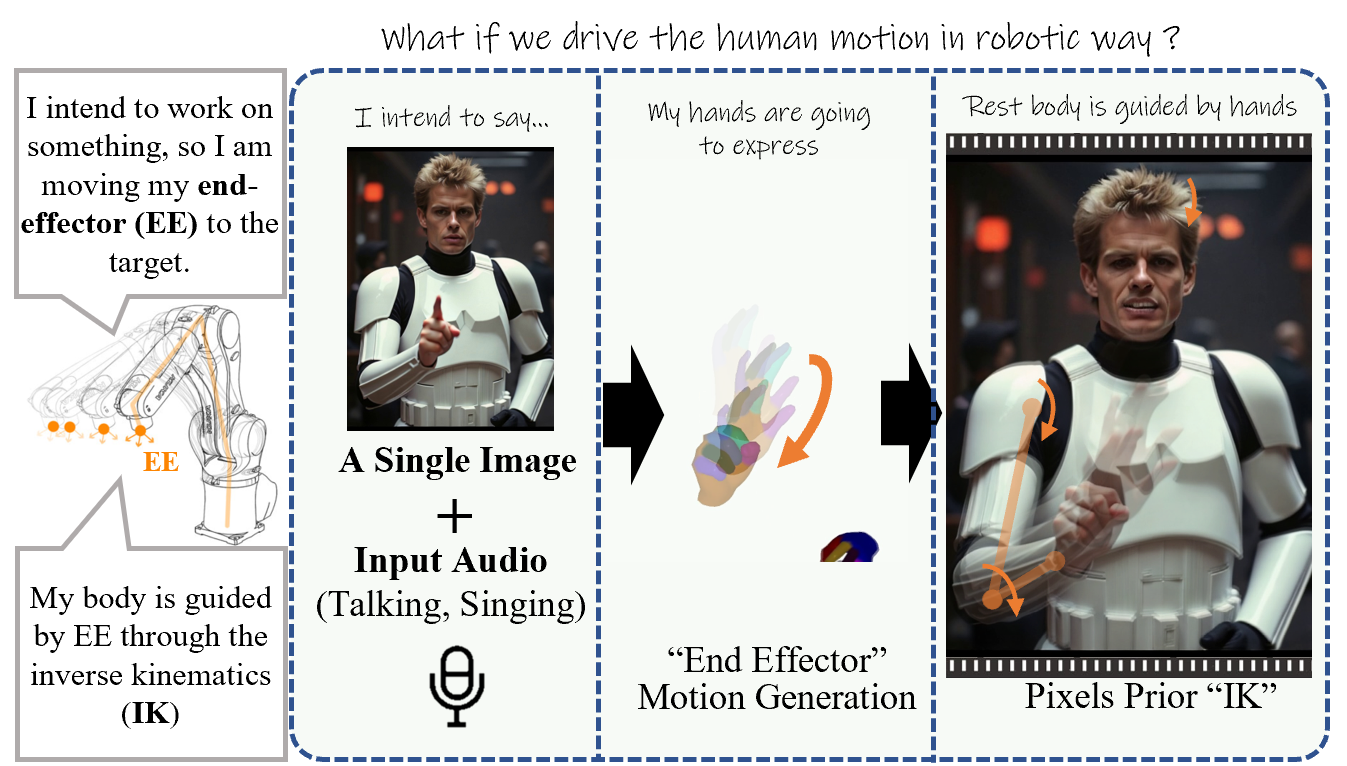

EMO2:端效器引导的音频驱动虚拟形象视频生成

概要:EMO2 是由 阿里巴巴集团智能计算研究院 提出的音频驱动虚拟形象生成方法。该方法通过输入单张角色图像和音频(如歌唱),生成包含丰富面部表情和手势的虚拟形象视频。与以往专注于全身或半身姿态生成的方法不同,EMO2 重新定义了任务流程,分为两个阶段:首先从音频生成手部姿态,然后采用扩散模型合成视频帧,将生成的手部姿态融入其中,以实现逼真的面部表情和身体动作。实验结果表明,EMO2 在视觉质量和同步精度方面优于现有方法,如 CyberHost 和 Vlogger。

标签:#EMO2 #音频驱动 #数字人 #视频生成 #手势生成

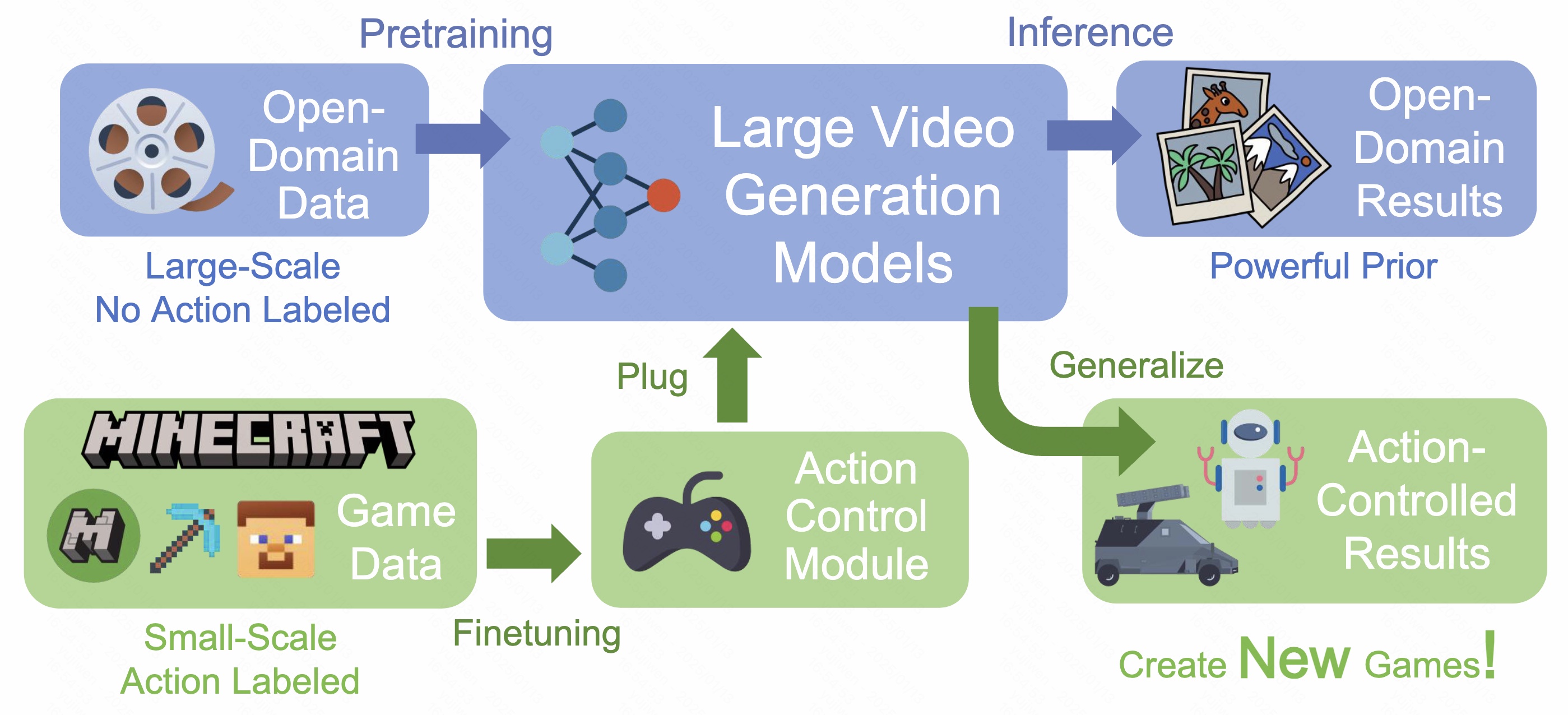

GameFactory:生成交互式视频创建新游戏

概要:GameFactory 是 KwaiVGI(快手视觉生成与交互中心)提出的一个新框架,旨在解决游戏视频生成中场景泛化的挑战。通过结合预训练大型视频生成模型的开放域生成能力和从小规模高质量数据集 GF-Minecraft 学习的动作控制模块,GameFactory 实现了无需依赖固定风格和环境即可创建多样化和新颖游戏的能力。

标签:#GameFactory #KwaiVGI #游戏生成 #视频生成

PASA:面向学术搜索的智能代理

概要:PaSa(Pa per Sa erch Agent)是由 字节跳动研究院 和 北京大学 的研究人员联合开发的学术论文搜索代理。该代理利用大型语言模型(LLM),能够自主决策,包括调用搜索工具、阅读论文以及选择相关参考文献,以提供复杂学术查询的全面准确结果。PaSa通过强化学习进行优化,使用了包含35,000个细粒度学术查询及对应论文的合成数据集AutoScholarQuery。此外,研究团队还开发了RealScholarQuery,这是一个收集真实世界学术查询的基准,用于评估PaSa在实际场景中的性能。尽管仅在合成数据上进行了训练,PaSa在RealScholarQuery上的表现显著优于现有基线方法,包括Google、Google Scholar、结合GPT-4的Google、ChatGPT(支持搜索的GPT-4)、GPT-4,以及基于GPT-4实现的PaSa。

标签:#PaSa #学术搜索 #LLM #强化学习 #字节跳动

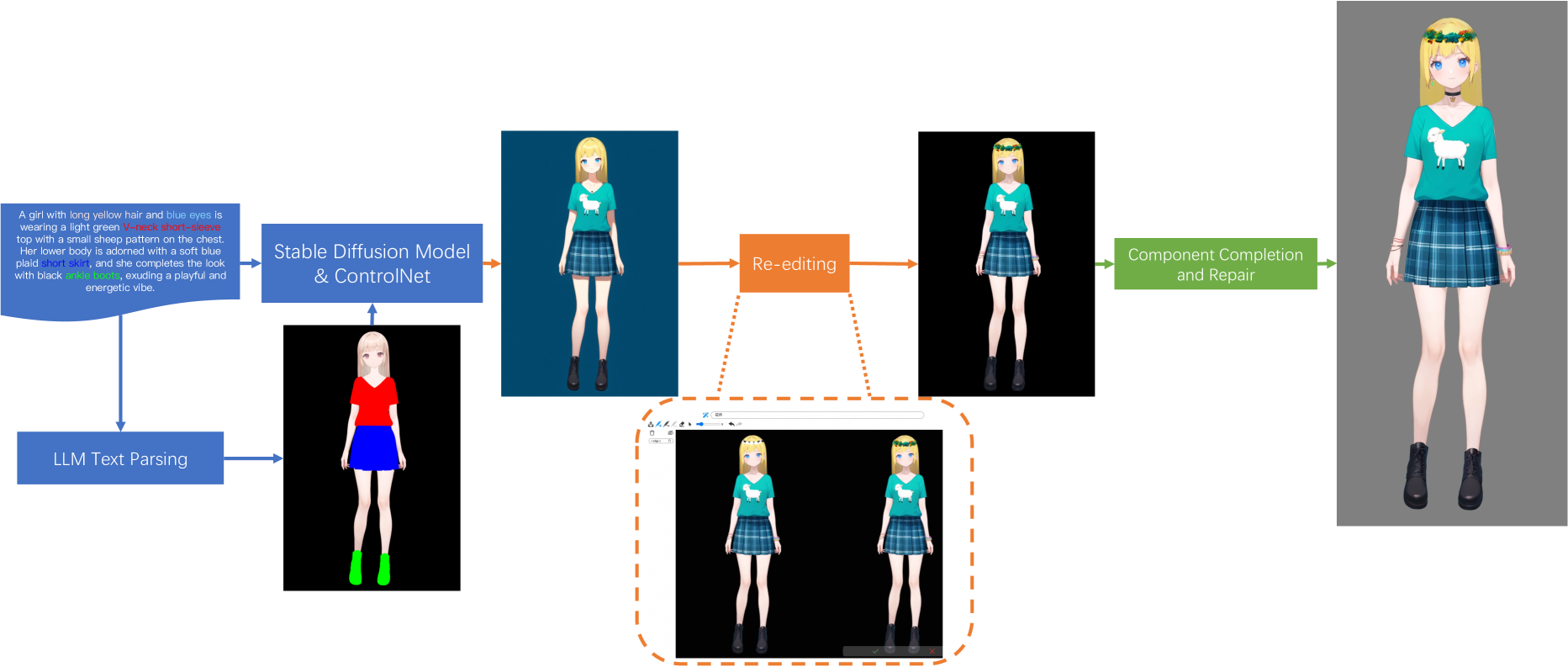

Textoon:基于文本生成生动的2D卡通角色

概要:Textoon 是由 Tongyi Lab, Alibaba Group 的研究团队提出的一种创新方法,旨在根据文本描述生成多样化的 2D 卡通角色,采用 Live2D 格式。该方法利用先进的语言和视觉模型,理解文本意图并生成相应的 2D 外观,使用户能够在不到一分钟的时间内创建出各种生动且可交互的 2D 角色。与传统的 3D 模型相比,Textoon 提供了一种更高效的替代方案,无需构建完整的 3D 模型即可模拟 3D 动作,同时采用轻量级的 HTML5 渲染,提高了可访问性和效率。

标签:#Textoon #Live2D #数字人 #2D卡通角色 #文生图