UniWorld刷榜多模态生成 | ComfyUI智能助手Copilot | SeedEdit 3.0升级图像编辑【AI周报】

UniWorld刷榜多模态生成 | ComfyUI智能助手Copilot | SeedEdit 3.0升级图像编辑【AI周报】

摘要

本周亮点:北大推出统一视觉框架UniWorld-V1;阿里发布Qwen3-Embedding检索模型;ComfyUI-Copilot简化工作流设计;SeedEdit 3.0升级图像编辑系统;RelationAdapter增强视觉关系迁移。

目录

- UniWorld‑V1:统一视觉理解、生成与编辑框架

- ComfyUI-Copilot:智能助手插件简化 ComfyUI 工作流设计

- Qwen3‑Embedding:先进的多尺寸文本嵌入与重排序模型系列

- RelationAdapter:学习与迁移视觉关系的轻量扩散插件

- IEAP:将复杂指令拆解为程序化原子操作的统一图像编辑框架

- SeedEdit 3.0:高质量文本指令驱动图像编辑系统

UniWorld‑V1:统一视觉理解、生成与编辑框架

概要:UniWorld‑V1 是由北京大学元组团队(PKU‑YuanGroup)提出的统一视觉模型,致力于在视觉理解、文本生成、图像编辑三大任务上实现一体化处理。该模型摒弃了传统的 VAE 架构,采用来自 SigLIP 的语义编码器,并融合 GPT‑4o 筛选的高质量编辑样本(724K+),仅利用 2.7M 数据训练即展现出在三个基准上的超越性能。项目已开源,提供完整的数据集、模型权重与训练/评估脚本,推动多任务视觉应用的可复现性与研究进展。

标签:#统一视觉模型 #视觉理解 #文本生成 #图像编辑 #高效训练

ComfyUI-Copilot:智能助手插件简化 ComfyUI 工作流设计

概要:ComfyUI‑Copilot 是由 Alibaba AIDC-AI 开发的 ComfyUI 大语言模型驱动插件,通过多智能体架构降低 AI 艺术创作门槛并提升工作效率。该工具集成了覆盖 7000+ 节点、62000+ 模型、9000+ 工作流的知识库,能智能推荐节点与模型、一键生成完整工作流,并提供自然语言交互界面。多轮评价测试表明,Copilot 显著加速了工作流构建过程,同时兼顾新手易用性与专业用户深度需求。项目已开源,提供完整安装包与演示资源。

标签:#工作流自动化 #多智能体 #大语言模型 #节点推荐 #ComfyUI

Qwen3‑Embedding:先进的多尺寸文本嵌入与重排序模型系列

概要:Qwen3‑Embedding 是由 阿里巴巴 Tongyi Lab 等 基于最新版 Qwen3 LLM 系列提出的文本嵌入与重排序系统。该模型通过多阶段训练管道融合了大规模弱监督预训练、多语言合成数据、监督微调以及模型合并技术,生成 0.6B、4B、8B 三个尺寸的嵌入与重排序模型。它在 MTEB、多语言检索、代码检索等多个任务上均实现了最新状态,尤其是 8B 嵌入模型在多语言基准 MTEB 中取得了 70.58 的第一名 。该系列模型以 Apache 2.0 协议开源,提供对多语种、长文本、指令增强等支持,适合多场景部署,并助力社区复现研究成果。

标签:#文本嵌入 #重排序 #多语言 #大模型 #检索优化

RelationAdapter:学习与迁移视觉关系的轻量扩散插件

概要:RelationAdapter 是由浙江大学与新加坡国立大学联合提出的轻量化扩散模块,专注于增强 Diffusion Transformer 在示例驱动图像编辑中的关系理解与迁移能力。该模块通过专门的注意力机制从图像对中提取视觉关系,并将其注入主干编辑网络,提升了模型对风格、结构和语义变化的感知能力。研究团队构建了包含 21.8 万个编辑示例对的 Relation252K 数据集,涵盖 218 种多样编辑任务。实验表明,RelationAdapter 在多个指标上显著优于现有方法,展现出强大的编辑泛化能力和结构一致性。该项目已开源,具备良好的插拔兼容性,可集成于现有扩散生成架构中,推动"图像对提示"编辑范式的发展。

标签:#图像编辑 #视觉关系建模 #扩散模型 #轻量模块 #示例驱动

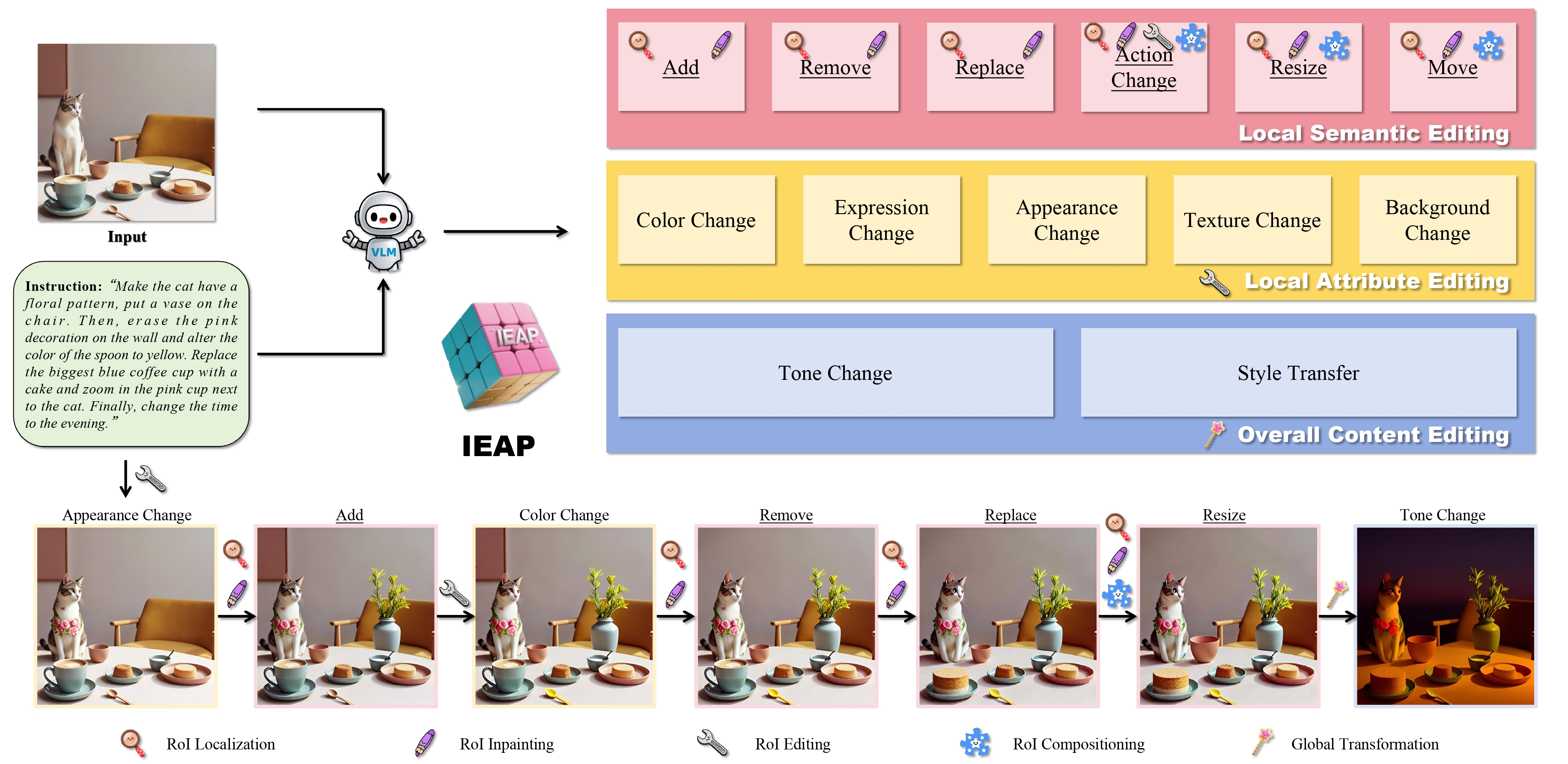

IEAP:将复杂指令拆解为程序化原子操作的统一图像编辑框架

概要:IEAP(Image Editing As Programs) 是由 新加坡国立大学 xML Lab 提出的图像编辑工具,基于 Diffusion Transformer(DiT)架构,旨在解决文本驱动图像编辑中结构不一致的复杂指令处理难题。IEAP 利用链式思维(CoT)推理将自然语言编辑指令拆分为一系列可组合、可执行的原子操作,然后通过轻量级适配器逐步运行这些操作,实现对结构布局发生变化的图像的高精度、多步编辑。实验证明,IEAP 在结构保持与结构变更场景下均优于现有基线,在复杂多步骤指令下表现尤其突出,比商业闭源模型生成更准确、语义一致性更高 。项目已在 GitHub 和 Hugging Face 开源,提供完整代码、模型与演示,推动指令驱动图像编辑工具的发展与可复现研究。

标签:#图像编辑 #指令驱动 #原子操作 #DiT

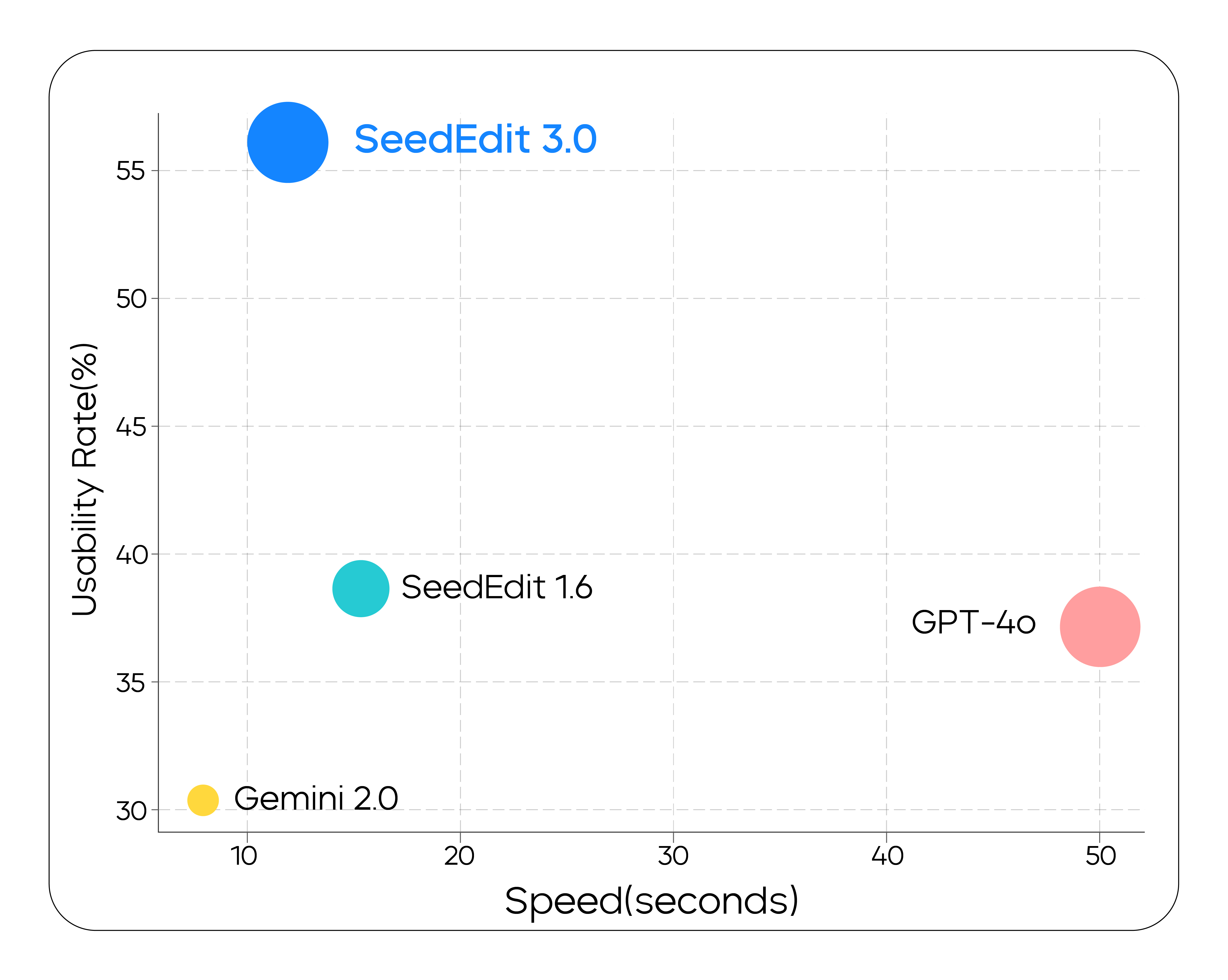

SeedEdit 3.0:高质量文本指令驱动图像编辑系统

概要:SeedEdit 3.0 是由 字节跳动 Seed 团队 推出的第三代图像编辑模型,旨在显著提升自然语言指令驱动的图像编辑品质与一致性。该版本基于文字生成图像模型 Seedream 3.0 构建,引入了“元信息”(meta-info)嵌入策略融合多源图像数据,并通过联合优化扩散损失与奖励函数,增强模型对指令执行和视觉风格保留的综合能力。根据内部评估,SeedEdit 3.0 在遵从编辑指令和 ID/IP (主体识别与版权信息)保留方面表现均优于先前版本和主流商业模型(如 GPT‑4o 与 Gemini 2.0),可用率提升至 56.1%。该模型支持对真实照片进行精细编辑,且在移除人物、场景重构、光影调整等任务中展示出色表现。项目已开放测试,未来将在更多平台上线。

标签:#图像编辑 #指令驱动 #文本到图像 #扩散模型 #高保真