Qwen 2.5 Coder: 多语言代码生成新高度,InstantDrag 实时交互式图像生成,Omnigen 多模态生成研究进展【AI 周报】

Qwen 2.5 Coder: 多语言代码生成新高度,InstantDrag 实时交互式图像生成,Omnigen 多模态生成研究进展【AI 周报】

摘要

本期周报涵盖 Qwen 2.5 Coder 的代码生成进展、InstantDrag 的交互式图像生成工具、以及 Omnigen 的多模态生成研究。此外,还介绍了 Diffusion-e2e-ft 扩散模型优化、LVCD 的线稿视频上色方法和 MoCoop 多模态合作学习。

目录

- Qwen 2.5 Coder: 代码生成的最新突破

- InstantDrag: 交互式图像拖拽生成新工具

- Diffusion-e2e-ft: 自监督扩散模型优化

- Omnigen: 灵活生成模型的研究进展

- LVCD: 基于扩散模型的线稿视频上色

- MoCoop: 多模态合作学习的新方法

Qwen 2.5 Coder: 代码生成的最新突破

概要: Qwen 2.5 Coder 是 QwenLM 团队推出的最新代码生成模型,专注于多语言编程任务。它通过精细化的预训练和微调,显著提高了代码生成、自动补全和代码理解的能力。该模型能够处理更复杂的代码逻辑,并支持多种编程语言,适用于各类编程场景和开发需求。Qwen 2.5 Coder 在主流代码生成基准上刷新了多个记录,展示了其在智能编程助手领域的广泛应用前景。

标签: #QwenLM #代码生成 #多语言支持 #编程工具 # LLM

InstantDrag: 交互式图像拖拽生成新工具

概要: InstantDrag 是由 SNU-VGILab 团队开发的交互式图像生成工具。用户只需通过简单的拖拽操作,即可实时调整图像中的细节,生成符合需求的视觉效果。该工具结合了深度学习技术与用户交互界面,支持实时图像修改,适合应用于艺术创作、广告设计等需要高效视觉调整的领域。InstantDrag 展现了交互式 AI 生成技术在设计中的潜力。

标签: #图像生成 #深度学习 #实时交互 #设计工具 #SNU-VGILab

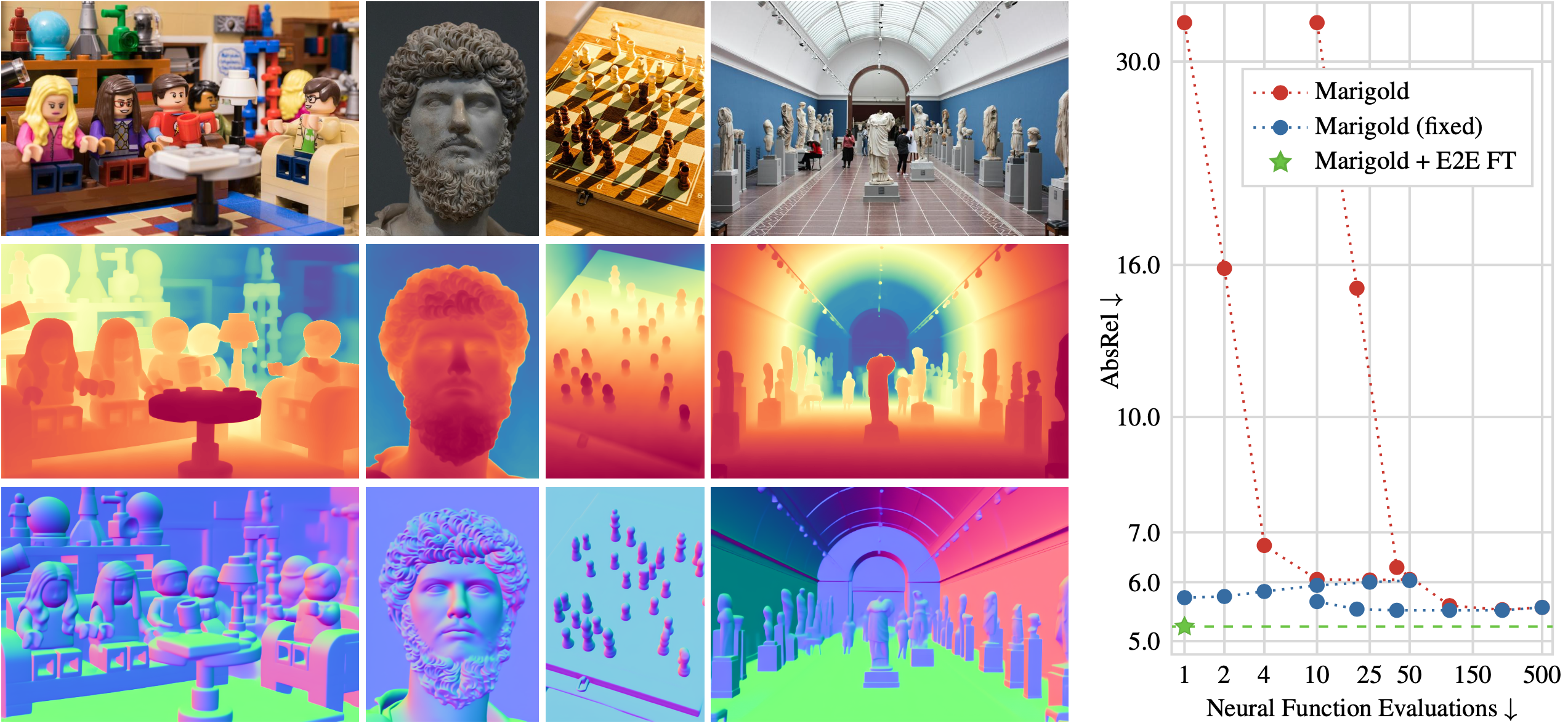

Diffusion-e2e-ft: 自监督扩散模型优化

概要: Diffusion-e2e-ft 是由 Visual Computing Institute 提出的端到端自监督学习方法,用于优化扩散模型的训练过程。该方法通过结合端到端的微调技术,大幅提升了扩散模型在图像生成任务中的效率和效果。Diffusion-e2e-ft 不仅缩短了训练时间,还提升了生成图像的质量,特别适用于大规模数据集的处理和生成任务。

标签: #扩散模型 #自监督学习 #端到端微调 #图像生成 #VisualComputingInstitute

Omnigen: 灵活生成模型的研究进展

概要: Omnigen 是由 VectorSpaceLab 提出的多模态生成模型,专注于处理不同类型的输入数据,如图像、文本、音频等。该模型通过创新的生成架构,能够有效解耦和处理不同模态之间的转换与一致性问题。Omnigen 展示了其在跨模态生成任务中的潜力,适用于多领域数据的生成与转换,例如图像到文本的生成或多模态内容合成。

标签: #多模态生成 #灵活模型 #数据转换 #跨模态 #VectorSpaceLab

LVCD: 基于扩散模型的线稿视频上色

概要: LVCD 是第一个用于参考线稿视频上色的扩散模型框架,利用大规模预训练的视频扩散模型生成颜色一致的动画视频。该方法通过 Sketch-guided ControlNet 控制线稿生成动画视频,并引入 参考注意力机制 实现颜色从参考帧到其他帧的迁移。LVCD 提出了一种序列采样方案,能够生成长时间一致的动画视频,特别适用于大幅动作场景。

标签: #视频扩散模型 #线稿上色 #时间一致性 #动画生成

MoCoop: 多模态合作学习的新方法

概要: MoCoop(Multimodal Cooperative Learning)提出了一种新的多模态合作学习方法,通过不同模态数据的协同学习,提升各模态的特征共享能力。该方法尤其适合视觉和文本等不同模态数据的处理,显著提高了多模态任务的效率和性能。MoCoop 在多个多模态基准上取得了优异表现,展示了其在跨模态理解和生成中的潜力。

标签: #多模态学习 #合作学习 #特征共享 #深度学习