Voxtral-Mini多模态音频 | HiDream-E1-1稀疏扩散图像编辑 | PusaV1高效视频生成【HF周报】

Voxtral-Mini多模态音频 | HiDream-E1-1稀疏扩散图像编辑 | PusaV1高效视频生成【HF周报】

摘要

本周亮点:Mistral推多模态音频模型,HiDream革新图像编辑,PusaV1高效视频生成。英伟达、LG等模型及Hermes-3、rStar-Coder数据集同步亮相,详情见正文。

目录

- Voxtral-Mini-3B-2507:Mistral AI发布的多模态音频模型

- EXAONE-4.0-32B:LG AI Research推出的双模推理大模型

- PusaV1:高效多任务视频生成与编辑新范式

- HiDream-E1-1:基于稀疏扩散Transformer的图像编辑模型

- Canary-Qwen-2.5B:英伟达开源的SOTA英文语音识别模型

- Hermes-3-Dataset:Nous Research发布的大规模对话数据集

- rStar-Coder:微软发布的大规模代码推理数据集

Voxtral-Mini-3B-2507:Mistral AI发布的多模态音频模型

概要:Mistral AI 发布 Voxtral-Mini-3B-2507,一款基于Ministral-3B增强的3B级多模态音频语言模型。该模型不仅保留了强大的文本理解能力,还具备卓越的音频处理功能,包括专用转录模式、长达40分钟的音频理解、内置问答与摘要、8种主流语言的自动检测与转录,以及直接从语音触发函数调用的能力。Voxtral-Mini支持32k长上下文,为实现复杂的语音交互应用提供了高效解决方案。

标签:#MistralAI #VoxtralMini #多模态音频 #语音识别 #函数调用

EXAONE-4.0-32B:LG AI Research推出的双模推理大模型

概要:LG AI Research 发布 EXAONE-4.0-32B,一个拥有320亿参数的多语言大模型。该模型创新性地集成了“非推理”和“推理”两种模式,以兼顾通用性与复杂任务处理能力。EXAONE-4.0支持128K超长上下文,具备Agent工具使用能力,并将多语言支持扩展至西班牙语、韩语和英语。其架构采用混合注意力机制和QK-Reorder-Norm等新技术,在多项基准测试中表现出色。

标签:#LGAIResearch #EXAONE4 #双模推理 #混合注意力 #多语言大模型

PusaV1:高效多任务视频生成与编辑新范式

概要:RaphaelLiu 发布 PusaV1,一个基于矢量化时间步适应(VTA)技术的高效视频生成模型。该模型在SOTA文生视频模型Wan2.1-T2V-14B基础上进行微调,以低于$500的成本和4K样本数据,实现了超越基线模型的性能,训练成本和数据量仅为基线的1/200和1/2500。PusaV1不仅在图生视频(I2V)任务上达到SOTA水平,还零样本解锁了视频续写、补全、转场等多种复杂任务。

标签:#PusaV1 #视频生成 #矢量化时间步 #高效微调 #多任务视频

HiDream-E1-1:基于稀疏扩散Transformer的图像编辑模型

概要:HiDream.ai 发布 HiDream-E1-1,一款基于其稀疏扩散Transformer架构(HiDream-I1)构建的图像编辑模型。该模型在EmuEdit和ReasonEdit等基准上表现出色,展示了强大的指令驱动图像内容修改能力。HiDream-E1-1集成了来自FLUX.1的VAE和Llama-3.1-8B的文本编码器,通过高效的架构和训练策略,为用户提供高质量、高效率的图像编辑体验。

标签:#HiDreamAI #HiDreamE1 #图像编辑 #稀疏扩散 #DiffusionTransformer

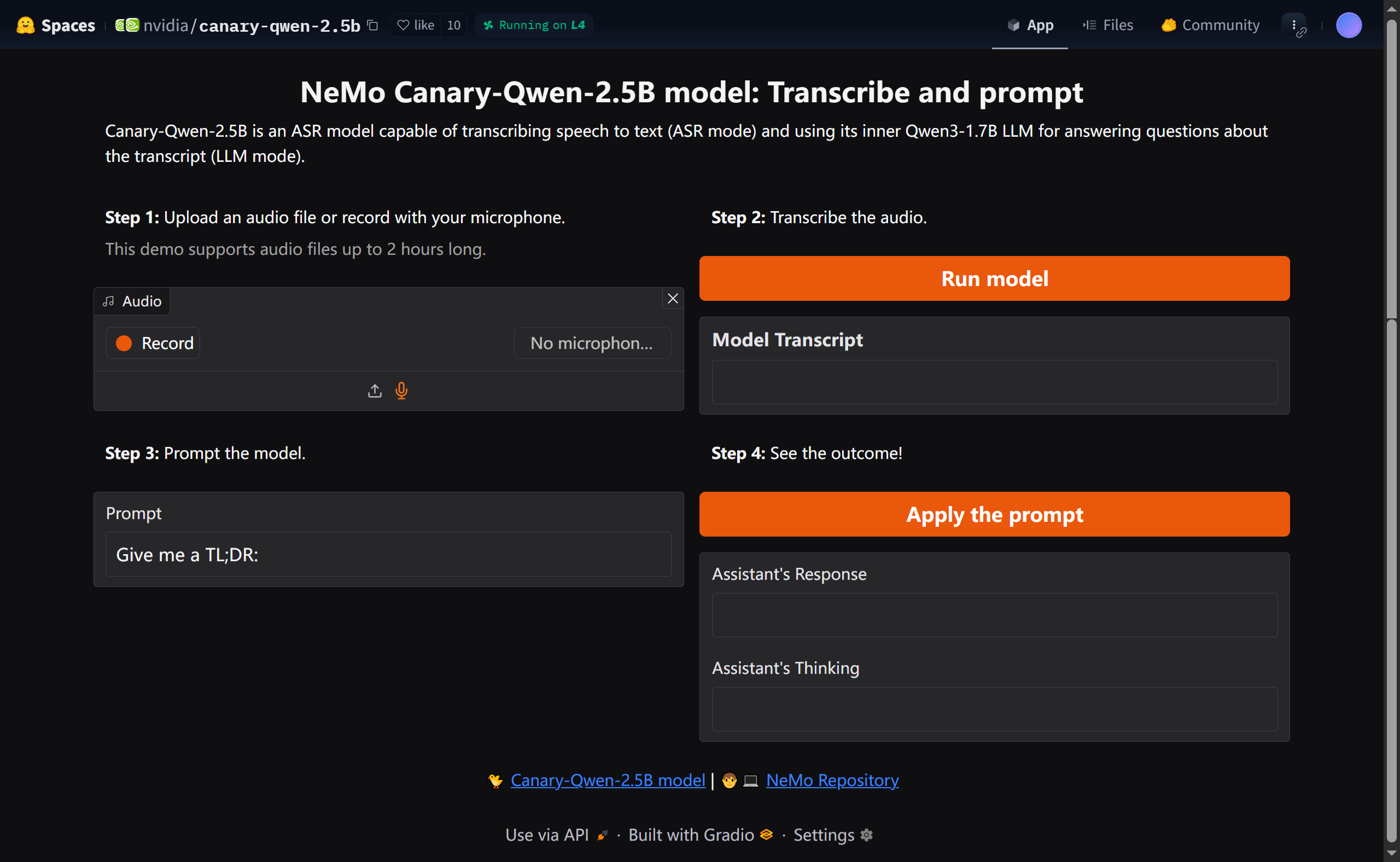

Canary-Qwen-2.5B:英伟达开源的SOTA英文语音识别模型

概要:英伟达(NVIDIA)发布 Canary-Qwen-2.5B,一款在多项英文语音识别基准上达到SOTA性能的25亿参数模型。该模型属于语音增强语言模型(SALM),集成了FastConformer编码器和基于Qwen3-1.7B的Transformer解码器。它支持纯转录(ASR)和语言模型(LLM)两种模式,前者专注于高精度语音转文本,后者则可用于对转录稿进行摘要、问答等后处理,为商业应用提供了强大而灵活的工具。

标签:#NVIDIA #CanaryQwen #语音识别 #SALM #FastConformer

Hermes-3-Dataset:Nous Research发布的大规模对话数据集

概要:Nous Research 发布 Hermes-3-Dataset,一个包含近百万(95.9万)条高质量对话的大规模数据集。该数据集旨在用于训练无偏见、无审查的AI助手,数据格式遵循system-human-gpt的对话结构,涵盖了代码生成、规划、创意写作、知识问答等多种复杂任务。Hermes-3的发布为社区训练更强大、更安全的开源模型提供了宝贵的资源。

标签:#NousResearch #Hermes3 #数据集 #对话数据 #AI助手

rStar-Coder:微软发布的大规模代码推理数据集

概要:微软(Microsoft)发布 rStar-Coder,一个规模宏大(超480GB)的、经过验证的代码推理数据集。该数据集旨在提升模型在编程竞赛级别的代码生成与推理能力,包含人类种子数据和合成数据两大类,并同时支持监督微调(SFT)和强化学习(RL)两种训练范式。rStar-Coder的发布,为训练下一代高性能代码大模型奠定了坚实的数据基础。

标签:#Microsoft #rStarCoder #代码推理 #编程竞赛 #大规模数据集