早上

9点多,自然醒吧,感觉现在睡7个小时就已经开始做梦了,非常浅的睡眠,于是就还是早起了点。起床之后的习惯还是不好,开始躺在床上刷短视频和打游戏。点了个叮咚买菜,玩到差不多11点多才下床拿我的菜。

中午

2025年2月23日大约 4 分钟

9点多,自然醒吧,感觉现在睡7个小时就已经开始做梦了,非常浅的睡眠,于是就还是早起了点。起床之后的习惯还是不好,开始躺在床上刷短视频和打游戏。点了个叮咚买菜,玩到差不多11点多才下床拿我的菜。

今天去参加了在徐汇西岸召开的2025GDC大会(Global Developer Conference),中文名叫全球开发者先锋大会,TA的官方介绍如下: 今年的主题是”模塑全球 无限可能“,围绕大模型,结合了算力、语料、基金等要素,聚焦具身智能、无人驾驶和科学智能等五大领域,及金融、医疗、智能制造等六大行业,做厚产业生态;以”社区的社区“为基础,打造高创新浓度、高创业热度、高人才密度的开发者生态。

more 注释之前的内容被视为文章摘要。

我们迄今为止最智能、最快速、最实用的模型,内置思考功能,将专家级智能带到每个人手中。

![图片 1:FLUX.1 Kontext [dev]](https://cdn.sanity.io/images/gsvmb6gz/production/d14326c68b9dd45088913aa19580f2c904be31af-940x377.jpg?rect=31,0,878,377&w=960&h=412&fit=max&auto=format)

直到最近,生成一致角色图像的最佳方式还是训练一个lora。你需要准备一组图片数据集,然后用它们训练FLUX lora。

除了让我们的 FLUX.1 Kontext [dev] 实现开源之外,我们还希望提供更多关于如何在不降低质量的前提下优化它的指导。

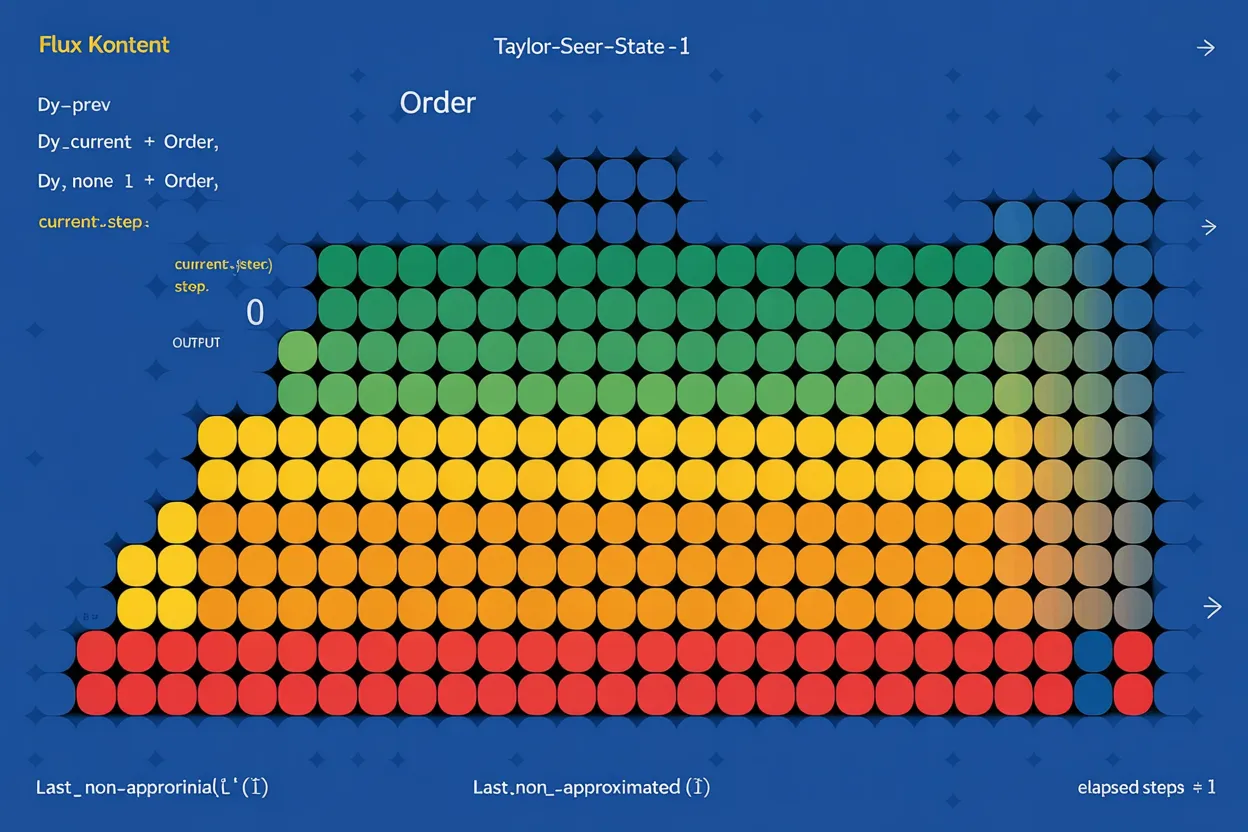

在这篇文章中,您将主要了解 TaylorSeer 优化,这是一种通过使用缓存的图像变化(导数)和从 Taylor 级数近似推导出的公式来近似中间图像预测的方法。

阿里巴巴 Ovis-U1 是一个仅3B参数的统一多模态模型,通过创新的六阶段训练,集成了理解、生成与编辑能力。该模型在 OpenCompass 基准上超越同级,生成和编辑能力媲美更大模型,展现了紧凑模型实现通用多模态能力的潜力。